Nền Tảng Vững Chắc Cho Kỷ Nguyên AI: Vai Trò Sống Còn Của Hạ Tầng Dữ Liệu

AI "Đói" Dữ Liệu – Và Martech Cũng Không Ngoại Lệ

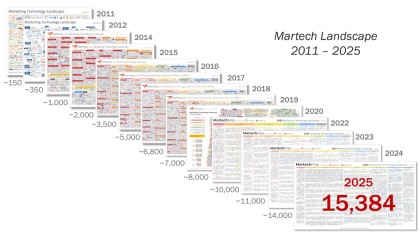

Trong các bài viết trước của chuỗi "Giải Mã Martech 2025", chúng ta đã khám phá sự bùng nổ của hơn 15.000 công cụ Martech và sức mạnh biến đổi của Trí tuệ Nhân tạo (AI) đang len lỏi vào mọi ngóc ngách của ngành. AI hứa hẹn mang lại khả năng cá nhân hóa siêu mục tiêu, tự động hóa thông minh, và những insight khách hàng sâu sắc chưa từng có. Nhưng có một sự thật không thể chối cãi: AI "đói" dữ liệu. Để các thuật toán AI hoạt động hiệu quả, để chúng "học" và trở nên "khôn ngoan" hơn, chúng cần được "nuôi dưỡng" bằng một nguồn dữ liệu dồi dào, chất lượng cao, và được tổ chức tốt.

Điều này đặt ra một câu hỏi then chốt: Nguồn "dinh dưỡng" đó đến từ đâu và được quản lý như thế nào? Câu trả lời nằm ở một yếu tố thường bị xem nhẹ nhưng lại có vai trò sống còn: Hạ tầng Dữ liệu (Data Infrastructure). Greg Brunk, CEO của MetaRouter (một công ty chuyên về giải pháp thu thập dữ liệu first-party), đã rất đúng khi nhấn mạnh trong các thảo luận về Martech 2025 rằng hạ tầng dữ liệu không chỉ đơn thuần là một ứng dụng Martech khác; nó chính là lớp nền tảng (foundational layer) mà toàn bộ Martech stack, đặc biệt là các ứng dụng AI, phải được xây dựng dựa trên đó.

Trong bối cảnh Martech ngày càng phức tạp và AI trở thành động lực chính, việc đầu tư vào một hạ tầng dữ liệu vững chắc không còn là một lựa chọn "nice-to-have", mà đã trở thành một yêu cầu chiến lược bắt buộc. Bài viết này của MarTech.org.vn sẽ đi sâu phân tích vai trò của hạ tầng dữ liệu, các thành phần chính, những thách thức và cơ hội, đặc biệt là trong bối cảnh đặc thù của thị trường Việt Nam.

1. Giải Mã Các Khái Niệm Cốt Lõi: CDW, Data Lake, và Sự Trỗi Dậy Của Lakehouse

Trước khi đi sâu hơn, chúng ta cần làm rõ một số thuật ngữ kỹ thuật quan trọng liên quan đến hạ tầng dữ liệu hiện đại:

-

Kho Dữ liệu (Data Warehouse - DW hoặc Cloud Data Warehouse - CDW):

- Định nghĩa: Một hệ thống lưu trữ trung tâm, được thiết kế để lưu trữ dữ liệu có cấu trúc (structured data) và bán cấu trúc (semi-structured data) từ nhiều nguồn khác nhau. Dữ liệu trong DW thường đã được làm sạch, chuyển đổi và tối ưu hóa cho mục đích phân tích và báo cáo (Business Intelligence - BI).

- Đặc điểm:

- Schema-on-write: Cấu trúc dữ liệu (schema) được định nghĩa trước khi dữ liệu được ghi vào.

- Tập trung vào dữ liệu lịch sử và tổng hợp.

- Hỗ trợ các truy vấn SQL phức tạp và các công cụ BI.

- Tính toàn vẹn và nhất quán dữ liệu cao.

- Trường hợp sử dụng: Phân tích hiệu suất kinh doanh, báo cáo quản trị, phân tích xu hướng lịch sử, hỗ trợ ra quyết định chiến lược.

- Ví dụ công nghệ CDW phổ biến: Google BigQuery, Amazon Redshift, Snowflake, Azure Synapse Analytics.

-

Hồ Dữ liệu (Data Lake):

- Định nghĩa: Một kho lưu trữ trung tâm, có khả năng lưu trữ lượng lớn dữ liệu thô (raw data) ở nhiều định dạng khác nhau, bao gồm cả dữ liệu có cấu trúc, bán cấu trúc và phi cấu trúc (unstructured data như hình ảnh, video, văn bản).

- Đặc điểm:

- Schema-on-read: Cấu trúc dữ liệu được áp dụng khi dữ liệu được đọc hoặc truy vấn, mang lại sự linh hoạt cao.

- Lưu trữ dữ liệu ở định dạng gốc, không cần chuyển đổi trước.

- Phù hợp cho các tác vụ Data Science, Machine Learning, và phân tích khám phá (exploratory analysis).

- Chi phí lưu trữ thường thấp hơn DW cho cùng một dung lượng.

- Trường hợp sử dụng: Huấn luyện mô hình Machine Learning, phân tích dữ liệu phi cấu trúc, lưu trữ dữ liệu IoT, xử lý dữ liệu lớn (Big Data processing).

- Ví dụ công nghệ Data Lake: Amazon S3, Google Cloud Storage, Azure Data Lake Storage, Hadoop Distributed File System (HDFS).

-

Nhà Kho Hồ Dữ Liệu (Data Lakehouse): Sự Hội Tụ Tinh Hoa

- Định nghĩa: Một kiến trúc dữ liệu mới nổi, kết hợp những ưu điểm tốt nhất của Data Warehouse và Data Lake. Lakehouse cố gắng mang lại độ tin cậy, hiệu suất và khả năng quản trị của DW cùng với sự linh hoạt, khả năng mở rộng và chi phí tối ưu của Data Lake.

- Đặc điểm:

- Cho phép truy vấn trực tiếp trên dữ liệu thô lưu trữ trong Data Lake bằng các công cụ và cú pháp tương tự như trên DW (thường thông qua các định dạng bảng mở như Apache Iceberg, Delta Lake, Apache Hudi).

- Hỗ trợ cả tác vụ BI truyền thống và các workload Data Science/ML trên cùng một nền tảng dữ liệu.

- Giảm thiểu việc sao chép và di chuyển dữ liệu giữa DW và Data Lake, đơn giản hóa kiến trúc.

- Cung cấp các tính năng quản trị dữ liệu (data governance), giao dịch ACID (Atomicity, Consistency, Isolation, Durability) trên Data Lake.

- Trường hợp sử dụng: Hầu hết các trường hợp sử dụng của cả DW và Data Lake, tạo ra một nền tảng dữ liệu thống nhất cho toàn doanh nghiệp.

- Ví dụ công nghệ hỗ trợ Lakehouse: Databricks (với Delta Lake), Snowflake (với khả năng truy vấn dữ liệu trên external stages), Google BigQuery (với BigLake), AWS (với Lake Formation và Redshift Spectrum).

Sự khác biệt và lựa chọn: Việc lựa chọn giữa CDW, Data Lake hay Lakehouse phụ thuộc vào nhu cầu cụ thể, khối lượng và loại dữ liệu, các trường hợp sử dụng phân tích, ngân sách và kỹ năng của đội ngũ. Tuy nhiên, xu hướng Lakehouse đang ngày càng trở nên hấp dẫn bởi khả năng cung cấp một giải pháp toàn diện, thống nhất, đặc biệt quan trọng trong kỷ nguyên AI khi cả dữ liệu có cấu trúc và phi cấu trúc đều cần thiết cho việc huấn luyện các mô hình thông minh.

2. So Sánh Các Nhà Cung Cấp Cloud Lớn và Giải Pháp Thay Thế

Khi nói đến việc xây dựng hạ tầng dữ liệu hiện đại, các nhà cung cấp dịch vụ điện toán đám mây lớn (Hyperscalers) đóng vai trò chủ đạo:

-

Amazon Web Services (AWS):

- Giải pháp CDW: Amazon Redshift.

- Giải pháp Data Lake: Amazon S3 (lưu trữ), AWS Glue (ETL, data catalog), AWS Lake Formation (xây dựng, bảo mật và quản lý data lake).

- Giải pháp Lakehouse: Kết hợp Redshift Spectrum (truy vấn S3), EMR (Big Data processing), và các dịch vụ AI/ML của AWS.

- Ưu điểm: Hệ sinh thái dịch vụ đa dạng và trưởng thành nhất, cộng đồng người dùng lớn, nhiều lựa chọn về instance types.

- Nhược điểm: Cấu trúc giá có thể phức tạp, một số dịch vụ có thể "lock-in" vào AWS.

-

Google Cloud Platform (GCP):

- Giải pháp CDW/Lakehouse: Google BigQuery (nổi tiếng với kiến trúc serverless, khả năng mở rộng và hiệu suất truy vấn cao). BigLake cho phép BigQuery truy vấn dữ liệu trên Cloud Storage và các nguồn khác.

- Giải pháp Data Lake: Google Cloud Storage.

- Dịch vụ hỗ trợ: Dataflow (stream & batch data processing), Dataproc (managed Spark & Hadoop), Vertex AI (nền tảng ML hợp nhất).

- Ưu điểm: Mạnh về phân tích dữ liệu, AI/ML, kiến trúc serverless giúp tối ưu chi phí, tích hợp tốt với các công cụ Google khác.

- Nhược điểm: Hệ sinh thái có thể chưa rộng bằng AWS ở một số mảng, thị phần đám mây tổng thể nhỏ hơn.

-

Microsoft Azure:

- Giải pháp CDW/Lakehouse: Azure Synapse Analytics (nền tảng phân tích hợp nhất, kết hợp data warehousing, big data analytics, và data integration).

- Giải pháp Data Lake: Azure Data Lake Storage (ADLS Gen2).

- Dịch vụ hỗ trợ: Azure Data Factory (ETL/ELT), Azure Databricks (managed Spark), Azure Machine Learning.

- Ưu điểm: Tích hợp mạnh mẽ với các sản phẩm Microsoft khác (Windows Server, SQL Server, Office 365, Power BI), phù hợp với các doanh nghiệp đã có sẵn hệ sinh thái Microsoft.

- Nhược điểm: Một số dịch vụ có thể cảm thấy phức tạp hơn cho người mới bắt đầu.

-

Các Giải Pháp Độc Lập/Thay Thế:

- Snowflake: Một nền tảng dữ liệu đám mây (Cloud Data Platform) độc lập, chạy trên cả AWS, Azure, và GCP. Nổi tiếng với kiến trúc tách biệt giữa lưu trữ và tính toán, khả năng chia sẻ dữ liệu dễ dàng, và hiệu suất cao. Snowflake cũng đang phát triển mạnh mẽ theo hướng Lakehouse.

- Databricks: Ban đầu tập trung vào Apache Spark, Databricks đã phát triển thành một nền tảng Lakehouse hàng đầu với Delta Lake, cung cấp giải pháp hợp nhất cho data engineering, data science, machine learning, và BI.

- Giải pháp On-premise/Hybrid Cloud: Đối với một số doanh nghiệp có yêu cầu đặc biệt về bảo mật, tuân thủ, hoặc đã có đầu tư lớn vào hạ tầng tại chỗ (on-premise), các giải pháp hybrid cloud (kết hợp on-premise và public cloud) hoặc các DW truyền thống (Teradata, Oracle Exadata) vẫn có thể là lựa chọn. Tuy nhiên, xu hướng chung đang dịch chuyển mạnh mẽ về cloud.

3. Tầm Quan Trọng Của Dữ Liệu First-Party Trong Thế Giới "Cookieless"

Trong bối cảnh các trình duyệt lớn như Google Chrome đang dần loại bỏ cookie của bên thứ ba (third-party cookies) và các quy định về quyền riêng tư ngày càng siết chặt, vai trò của dữ liệu của bên thứ nhất (first-party data) trở nên quan trọng hơn bao giờ hết.

- First-party data là gì? Là dữ liệu mà doanh nghiệp tự thu thập trực tiếp từ khách hàng và người dùng của mình thông qua các tương tác trên website, ứng dụng di động, CRM, điểm bán hàng (POS), chương trình khách hàng thân thiết, khảo sát, v.v.

- Tại sao First-party data lại quan trọng?

- Độ tin cậy cao: Doanh nghiệp biết rõ nguồn gốc và cách thức thu thập dữ liệu này.

- Tính liên quan cao: Dữ liệu phản ánh trực tiếp hành vi và sở thích của chính khách hàng của doanh nghiệp.

- Tuân thủ quyền riêng tư tốt hơn: Doanh nghiệp có thể trực tiếp xin sự đồng ý (consent) từ người dùng để thu thập và sử dụng dữ liệu của họ, đảm bảo tính minh bạch.

- Lợi thế cạnh tranh bền vững: First-party data là tài sản độc quyền, không thể dễ dàng sao chép bởi đối thủ.

- Nền tảng cho cá nhân hóa và AI: Đây là nguồn dữ liệu quý giá nhất để xây dựng chân dung khách hàng 360 độ, huấn luyện các mô hình AI cá nhân hóa và phân tích dự đoán.

Chiến Lược Thu Thập, Làm Giàu và Quản Lý Sự Đồng Ý (Consent Management) Đối Với First-Party Data tại Việt Nam:

- Chiến lược thu thập:

- Tối ưu hóa các điểm chạm trực tiếp: Website (đăng ký tài khoản, newsletter, form liên hệ), ứng dụng di động (theo dõi hành vi trong app), CRM (ghi nhận tương tác khách hàng), POS (lịch sử mua hàng tại cửa hàng).

- Chương trình khách hàng thân thiết: Khuyến khích khách hàng chia sẻ thông tin để nhận ưu đãi.

- Nội dung tương tác (Interactive Content): Quizzes, polls, surveys để thu thập thông tin về sở thích, nhu cầu.

- Sự kiện trực tuyến và ngoại tuyến: Thu thập thông tin đăng ký, phản hồi sau sự kiện.

- Progressive Profiling: Thu thập thông tin khách hàng từ từ qua nhiều lần tương tác, thay vì yêu cầu một form dài ngay từ đầu.

- Làm giàu dữ liệu (Data Enrichment):

- Kết hợp dữ liệu từ các nguồn first-party khác nhau để có cái nhìn toàn diện hơn.

- Sử dụng dữ liệu của bên thứ hai (second-party data - dữ liệu từ đối tác tin cậy, có sự đồng ý) một cách cẩn trọng.

- Cập nhật và làm sạch dữ liệu định kỳ.

- Quản lý sự đồng ý theo luật Việt Nam (Nghị định 13/2023/NĐ-CP):

- Minh bạch: Thông báo rõ ràng cho người dùng về mục đích thu thập, phạm vi sử dụng, thời gian lưu trữ dữ liệu, và các bên thứ ba có thể được chia sẻ dữ liệu.

- Sự đồng ý rõ ràng (Explicit Consent): Cần có sự đồng ý tự nguyện, cụ thể và được thông tin đầy đủ từ người dùng trước khi thu thập và xử lý dữ liệu cá nhân, đặc biệt là dữ liệu nhạy cảm.

- Quyền của chủ thể dữ liệu: Đảm bảo người dùng có quyền truy cập, chỉnh sửa, xóa dữ liệu của mình, quyền rút lại sự đồng ý, quyền phản đối việc xử lý dữ liệu.

- An toàn dữ liệu: Áp dụng các biện pháp kỹ thuật và tổ chức phù hợp để bảo vệ dữ liệu cá nhân khỏi bị truy cập, sử dụng, thay đổi hoặc phá hủy trái phép.

- Lưu trữ hồ sơ đồng ý: Ghi nhận và lưu trữ bằng chứng về sự đồng ý của người dùng.

- Doanh nghiệp Việt Nam cần xây dựng hoặc tích hợp các Nền tảng Quản lý Sự Đồng Ý (Consent Management Platforms - CMPs) để quản lý hiệu quả việc này.

4. Vai Trò Của CDW/Lakehouse Trong Việc Hợp Nhất Dữ Liệu Silo, Tạo "Single Source of Truth"

Một trong những thách thức lớn nhất của doanh nghiệp, đặc biệt tại Việt Nam, là tình trạng "dữ liệu silo" – dữ liệu bị phân mảnh, cô lập trong các hệ thống, phòng ban khác nhau (Marketing, Sales, Chăm sóc khách hàng, Kế toán...). Điều này dẫn đến:

- Cái nhìn không đầy đủ và thiếu nhất quán về khách hàng.

- Khó khăn trong việc phân tích và ra quyết định dựa trên dữ liệu.

- Lãng phí tài nguyên khi các phòng ban cùng thu thập và xử lý những dữ liệu giống nhau.

- Trải nghiệm khách hàng rời rạc, thiếu liền mạch.

CDW và đặc biệt là Lakehouse đóng vai trò then chốt trong việc phá vỡ các silo này và tạo ra một "nguồn sự thật duy nhất" (Single Source of Truth - SSOT) về dữ liệu khách hàng và hoạt động kinh doanh.

- Hợp nhất dữ liệu: Thu thập và tích hợp dữ liệu từ tất cả các nguồn (website, app, CRM, ERP, POS, mạng xã hội, quảng cáo...) vào một kho lưu trữ trung tâm.

- Chuẩn hóa và làm sạch: Áp dụng các quy trình để đảm bảo dữ liệu nhất quán, chính xác và đáng tin cậy.

- Cung cấp bức tranh 360 độ về khách hàng: Giúp hiểu rõ hành trình, hành vi, sở thích và nhu cầu của từng khách hàng.

- Nền tảng cho phân tích nâng cao và AI: Một SSOT là điều kiện tiên quyết để xây dựng các mô hình AI hiệu quả, thực hiện phân tích dự đoán và cá nhân hóa trải nghiệm.

5. Quy Trình Xây Dựng Data Pipeline (ETL/ELT) và Các Công Cụ Phổ Biến

Data Pipeline là chuỗi các quy trình và công nghệ được sử dụng để di chuyển dữ liệu từ nguồn đến đích (thường là CDW/Lakehouse) và biến đổi nó thành định dạng có thể sử dụng được cho phân tích. Hai mô hình phổ biến là ETL và ELT:

-

ETL (Extract - Transform - Load):

- Extract (Trích xuất): Lấy dữ liệu từ các hệ thống nguồn.

- Transform (Biến đổi): Dữ liệu được làm sạch, chuẩn hóa, tổng hợp, và chuyển đổi cấu trúc tại một máy chủ trung gian (staging server) trước khi được tải vào Data Warehouse.

- Load (Tải): Dữ liệu đã biến đổi được tải vào Data Warehouse.

- Ưu điểm: DW chỉ chứa dữ liệu đã được xử lý, chất lượng cao, tối ưu cho truy vấn. Phù hợp với dữ liệu có cấu trúc và yêu cầu tuân thủ nghiêm ngặt.

- Nhược điểm: Kém linh hoạt, việc biến đổi trước có thể mất thời gian và bỏ sót dữ liệu thô có giá trị cho các phân tích sau này.

-

ELT (Extract - Load - Transform):

- Extract (Trích xuất): Lấy dữ liệu từ các hệ thống nguồn.

- Load (Tải): Dữ liệu thô được tải trực tiếp vào Data Lake hoặc khu vực lưu trữ thô của Lakehouse.

- Transform (Biến đổi): Việc làm sạch, chuẩn hóa và biến đổi dữ liệu được thực hiện bên trong Data Lake/Lakehouse khi cần thiết cho các mục đích phân tích cụ thể, thường bằng sức mạnh tính toán của chính nền tảng đó.

- Ưu điểm: Linh hoạt hơn, lưu trữ được toàn bộ dữ liệu thô, tận dụng được sức mạnh xử lý của các nền tảng dữ liệu hiện đại. Phù hợp với Big Data, dữ liệu phi cấu trúc và các workload Data Science/ML.

- Nhược điểm: Cần quản lý cẩn thận để tránh Data Lake trở thành "data swamp" (đầm lầy dữ liệu) nếu không có quy trình quản trị tốt.

Các công cụ Data Pipeline phổ biến:

- Mã nguồn mở: Apache NiFi, Apache Airflow (workflow orchestration), Apache Kafka (streaming data).

- Dịch vụ Cloud: AWS Glue, Azure Data Factory, Google Cloud Dataflow, Fivetran, Stitch Data, Informatica Intelligent Cloud Services.

- Tích hợp sẵn trong CDW/Lakehouse: Nhiều nền tảng như Snowflake, Databricks, BigQuery cung cấp các công cụ và khả năng tích hợp dữ liệu mạnh mẽ.

6. Quản Trị Dữ Liệu (Data Governance): "Luật Chơi" Cho Hạ Tầng Dữ Liệu

Xây dựng một hạ tầng dữ liệu hiện đại không chỉ là về công nghệ, mà còn là về con người và quy trình. Quản trị Dữ liệu (Data Governance) là một framework bao gồm các chính sách, quy tắc, tiêu chuẩn, quy trình và vai trò trách nhiệm để đảm bảo rằng dữ liệu của tổ chức được quản lý một cách an toàn, hiệu quả, nhất quán và tuân thủ các quy định.

-

Các trụ cột chính của Data Governance:

- Chất lượng Dữ liệu (Data Quality): Đảm bảo dữ liệu chính xác, đầy đủ, nhất quán, kịp thời và phù hợp với mục đích sử dụng.

- Bảo mật Dữ liệu (Data Security): Bảo vệ dữ liệu khỏi bị truy cập, sử dụng, thay đổi hoặc phá hủy trái phép.

- Quyền riêng tư Dữ liệu (Data Privacy): Tuân thủ các quy định về bảo vệ dữ liệu cá nhân (như Nghị định 13 tại Việt Nam, GDPR tại EU).

- Khả năng truy cập Dữ liệu (Data Accessibility): Đảm bảo những người dùng được ủy quyền có thể truy cập dữ liệu họ cần một cách dễ dàng và kịp thời.

- Quản lý Dữ liệu tổng thể (Master Data Management - MDM): Tạo và duy trì một phiên bản "vàng" (golden record) cho các thực thể dữ liệu quan trọng (khách hàng, sản phẩm...).

- Quản lý Siêu dữ liệu (Metadata Management): Quản lý thông tin mô tả về dữ liệu (nguồn gốc, định nghĩa, định dạng, mối quan hệ...).

- Tuân thủ (Compliance): Đảm bảo việc quản lý và sử dụng dữ liệu tuân thủ các quy định pháp luật và chính sách nội bộ.

-

Vai trò và Trách nhiệm:

- Data Stewards: Những người chịu trách nhiệm về chất lượng và định nghĩa của các tập dữ liệu cụ thể trong lĩnh vực của họ.

- Data Owners: Thường là lãnh đạo cấp cao, chịu trách nhiệm cuối cùng về một hoặc nhiều miền dữ liệu.

- Data Governance Council: Hội đồng gồm đại diện từ các bộ phận khác nhau, chịu trách nhiệm xây dựng và giám sát việc thực thi các chính sách Data Governance.

-

Công cụ hỗ trợ Data Governance:

- Data Catalog (ví dụ: Alation, Collibra, AWS Glue Data Catalog, Azure Purview).

- Công cụ Quản lý Chất lượng Dữ liệu.

- Công cụ MDM.

-

Sự cần thiết của Data Governance tại Việt Nam:

- Trong bối cảnh Nghị định 13 có hiệu lực, việc xây dựng một framework Data Governance mạnh mẽ là yêu cầu cấp thiết đối với các doanh nghiệp Việt Nam để đảm bảo tuân thủ và xây dựng lòng tin với khách hàng.

- Giúp giải quyết vấn đề "data silos" và cải thiện chất lượng dữ liệu, tạo nền tảng vững chắc cho chuyển đổi số và ứng dụng AI.

7. Mối Quan Hệ IT/Engineering & Marketing: Từ Xung Đột Đến Hợp Lực

Trong quá khứ, mối quan hệ giữa bộ phận IT/Engineering và Marketing thường có nhiều bất đồng. Marketing muốn có dữ liệu nhanh, linh hoạt để thử nghiệm các ý tưởng mới, trong khi IT tập trung vào sự ổn định, bảo mật và tuân thủ của hệ thống. Tuy nhiên, trong kỷ nguyên Martech và AI, sự hợp tác chặt chẽ giữa hai bộ phận này không còn là tùy chọn mà là yếu tố sống còn.

- Thay đổi vai trò:

- Marketing: Cần trở nên "data-savvy" hơn, hiểu biết về các khái niệm cơ bản của hạ tầng dữ liệu, quy trình dữ liệu và các yêu cầu về tuân thủ. Họ cần xác định rõ nhu cầu dữ liệu và mục tiêu kinh doanh để IT/Engineering có thể xây dựng giải pháp phù hợp.

- IT/Engineering: Cần hiểu rõ hơn về mục tiêu kinh doanh và các trường hợp sử dụng Martech của bộ phận Marketing. Họ cần chuyển từ vai trò "người gác cổng" sang "người hỗ trợ, đối tác" (enabler, partner), cung cấp các nền tảng dữ liệu linh hoạt, an toàn và dễ tiếp cận.

- Mô hình hợp tác hiệu quả:

- Thành lập các đội ngũ đa chức năng (Cross-functional Teams): Bao gồm thành viên từ Marketing, IT, Data Science, Business Analysts để cùng làm việc trong các dự án Martech và dữ liệu.

- Xây dựng quy trình phối hợp rõ ràng: Sử dụng các framework như RACI (Responsible, Accountable, Consulted, Informed) để xác định rõ vai trò và trách nhiệm của từng bên trong các dự án dữ liệu.

- Giao tiếp thường xuyên và cởi mở: Tạo các kênh giao tiếp hiệu quả để hai bên có thể chia sẻ thông tin, thách thức và cùng nhau tìm giải pháp.

- Đồng sở hữu mục tiêu (Shared Goals): Cả Marketing và IT cần có những mục tiêu chung liên quan đến việc sử dụng dữ liệu để thúc đẩy tăng trưởng kinh doanh.

- Kỹ năng cần có ở cả hai phía:

- Marketing: Data literacy, hiểu biết về Martech stack, khả năng diễn đạt yêu cầu kỹ thuật.

- IT/Engineering: Hiểu biết về Marketing, tư duy lấy khách hàng làm trung tâm, kỹ năng giao tiếp với các bên phi kỹ thuật.

- Thực trạng tại Việt Nam:

- Nhiều doanh nghiệp Việt vẫn còn khoảng cách lớn giữa Marketing và IT.

- Cần có sự thay đổi từ cấp lãnh đạo để thúc đẩy văn hóa hợp tác và phá vỡ các rào cản phòng ban.

- Sự thiếu hụt nhân sự có khả năng "nói hai thứ tiếng" (cả Marketing và Kỹ thuật) là một thách thức.

8. Case Study (Giả Định): Minh Chứng Sức Mạnh Của Hạ Tầng Dữ Liệu Tại Việt Nam

-

Case Study 1: Một Công Ty Bán Lẻ Đa Kênh Việt Nam Xây Dựng Lakehouse Để Cá Nhân Hóa Trải Nghiệm Khách Hàng

- Thách thức: Dữ liệu khách hàng phân mảnh từ website TMĐT, ứng dụng di động, hệ thống POS tại cửa hàng, chương trình khách hàng thân thiết, và các trang mạng xã hội. Khó khăn trong việc hiểu toàn diện hành trình khách hàng và cá nhân hóa ưu đãi.

- Giải pháp:

- Triển khai Data Lakehouse trên nền tảng Cloud (ví dụ: Databricks trên AWS hoặc Google Cloud).

- Xây dựng các Data Pipeline (sử dụng Fivetran và Airflow) để thu thập và hợp nhất dữ liệu từ tất cả các nguồn vào Lakehouse.

- Xây dựng mô hình dữ liệu khách hàng 360 độ (Customer 360) trên Lakehouse.

- Sử dụng các công cụ BI (Power BI, Tableau) kết nối với Lakehouse để phân tích hành vi khách hàng và hiệu quả chiến dịch.

- Huấn luyện các mô hình AI/ML trên Lakehouse để:

- Phân khúc khách hàng tự động.

- Đề xuất sản phẩm cá nhân hóa trên website/app.

- Gửi email/SMS marketing với nội dung và ưu đãi được cá nhân hóa.

- Dự đoán khả năng khách hàng rời bỏ và đưa ra biện pháp giữ chân.

- Kết quả (dự kiến): Tăng tỷ lệ chuyển đổi, tăng giá trị đơn hàng trung bình, cải thiện lòng trung thành của khách hàng, tối ưu hóa chi phí marketing.

- Case Study 2: Một Công Ty Fintech Việt Nam Sử Dụng CDW Để Chống Gian Lận và Phân Tích Rủi Ro

- Thách thức: Cần xử lý lượng lớn giao dịch theo thời gian thực, phát hiện các hành vi gian lận tiềm ẩn và đánh giá rủi ro tín dụng một cách nhanh chóng và chính xác.

- Giải pháp:

- Xây dựng Cloud Data Warehouse (ví dụ: Google BigQuery hoặc Snowflake) để lưu trữ và phân tích dữ liệu giao dịch, dữ liệu người dùng, và các nguồn dữ liệu bên ngoài.

- Sử dụng các công cụ ELT để tải dữ liệu real-time và batch vào CDW.

- Xây dựng các mô hình AI/ML trên CDW để:

- Phát hiện mẫu hình gian lận (Fraud Detection).

- Đánh giá điểm tín dụng (Credit Scoring).

- Phân tích rủi ro danh mục.

- Tích hợp kết quả phân tích AI vào hệ thống vận hành để tự động cảnh báo hoặc chặn các giao dịch đáng ngờ.

- Kết quả (dự kiến): Giảm thiểu tổn thất do gian lận, cải thiện quy trình thẩm định tín dụng, đảm bảo tuân thủ quy định của Ngân hàng Nhà nước.

9. Chi Phí Triển Khai, Vận Hành và Lộ Trình Cho SMEs Việt Nam

-

Các yếu tố chi phí:

- Chi phí bản quyền/sử dụng dịch vụ Cloud: Tính theo dung lượng lưu trữ, lượng dữ liệu xử lý, số giờ sử dụng máy tính, băng thông mạng.

- Chi phí công cụ Data Pipeline, Data Governance, BI: Nhiều công cụ có mô hình SaaS trả theo tháng/năm.

- Chi phí nhân sự: Lương cho Data Engineers, Data Analysts, Data Scientists, Martech Specialists. Đây thường là khoản chi phí lớn nhất.

- Chi phí tư vấn và triển khai ban đầu: Nếu thuê đối tác bên ngoài.

- Chi phí đào tạo.

- Tối ưu chi phí:

- Sử dụng các dịch vụ serverless hoặc auto-scaling trên Cloud để chỉ trả cho những gì thực sự sử dụng.

- Chọn các công cụ mã nguồn mở hoặc các phiên bản miễn phí/chi phí thấp cho các nhu cầu cơ bản.

- Tối ưu hóa các truy vấn và quy trình xử lý dữ liệu để giảm chi phí tính toán.

- Đầu tư vào đào tạo nhân sự nội bộ để giảm sự phụ thuộc vào chuyên gia bên ngoài.

- Lộ trình cho SMEs Việt Nam:

- Bắt đầu nhỏ (Start Small):

- Tập trung vào việc thu thập và hợp nhất dữ liệu first-party quan trọng nhất (ví dụ: dữ liệu từ website, CRM cơ bản, danh sách email).

- Sử dụng các công cụ miễn phí hoặc chi phí thấp (Google Analytics, Google Sheets làm "data warehouse" tạm thời, các công cụ email marketing có tính năng phân tích).

- Xây dựng văn hóa dựa trên dữ liệu từ những bước nhỏ.

- Từng bước nâng cấp (Scale Gradually):

- Khi có thêm ngân sách và nhu cầu, đầu tư vào một CRM tốt hơn, một công cụ Marketing Automation cơ bản.

- Xem xét sử dụng các giải pháp CDW/Lakehouse trên Cloud với quy mô nhỏ (ví dụ: BigQuery sandbox, các gói khởi đầu của Snowflake/Databricks).

- Thuê freelancer hoặc agency part-time để hỗ trợ các tác vụ phân tích dữ liệu phức tạp hơn.

- Tập trung vào ROI: Luôn đặt câu hỏi liệu việc đầu tư vào một công cụ hay một dự án dữ liệu có mang lại lợi tức cụ thể cho kinh doanh hay không.

- Đào tạo và phát triển nhân sự: Khuyến khích nhân viên học các kỹ năng về dữ liệu và Martech.

- Bắt đầu nhỏ (Start Small):

Kết Luận: Hạ Tầng Dữ Liệu – Không Chỉ Là "Ống Nước" Mà Là "Mạch Máu" Của Doanh Nghiệp Số

Trong kỷ nguyên Martech được dẫn dắt bởi AI, hạ tầng dữ liệu không còn đơn thuần là một "phần phụ trợ kỹ thuật" hay những "đường ống dẫn nước" vô tri. Nó đã thực sự trở thành "mạch máu" (lifeblood) của doanh nghiệp số, nuôi dưỡng mọi hoạt động từ thấu hiểu khách hàng, cá nhân hóa trải nghiệm, tối ưu hóa chiến dịch, cho đến việc đưa ra những quyết định chiến lược dựa trên bằng chứng vững chắc.

Đối với các doanh nghiệp Việt Nam, việc đầu tư vào một hạ tầng dữ liệu hiện đại, linh hoạt và có khả năng mở rộng không còn là một sự lựa chọn xa xỉ, mà là một yêu cầu chiến lược cấp bách. Đó là nền tảng để:

- Khai thác tối đa tiềm năng của AI và Machine Learning.

- Tuân thủ các quy định ngày càng nghiêm ngặt về bảo vệ dữ liệu cá nhân (Nghị định 13).

- Xây dựng lợi thế cạnh tranh bền vững trong một thị trường ngày càng khốc liệt.

- Phá vỡ các "data silos" và thúc đẩy văn hóa hợp tác dựa trên dữ liệu trong toàn tổ chức.

Hành trình xây dựng một hạ tầng dữ liệu vững chắc có thể đầy thách thức, đòi hỏi sự đầu tư về thời gian, tiền bạc và nỗ lực thay đổi tư duy. Tuy nhiên, phần thưởng mang lại – khả năng biến dữ liệu thành tài sản chiến lược, thành động lực tăng trưởng – là vô cùng to lớn.

MarTech.org.vn tin rằng, với sự quyết tâm của lãnh đạo, sự hợp tác chặt chẽ giữa các phòng ban, và sự hỗ trợ từ một cộng đồng Martech ngày càng lớn mạnh, các doanh nghiệp Việt Nam hoàn toàn có thể xây dựng được những nền tảng dữ liệu vững chắc, sẵn sàng cho kỷ nguyên AI và những thành công vượt trội trong tương lai.

Tác giả: VP Hội

Bài viết liên quan

"Cơn Sốt AI" Đổ Bộ Vào Martech: Thay Đổi Cuộc Chơi Hay Chỉ Là Xu Hướng Nhất Thời?

Trong bài viết này, chúng ta sẽ zoom cận cảnh vào một trong những động lực mạnh mẽ nhất, một "cơn sóng thần" đang định hình lại toàn bộ địa hạt công nghệ marketing: Trí tuệ Nhân tạo (AI). Báo cáo...

MarTech 2025: 15.000+ Công Cụ! Con Số Khủng Khiếp Này Nói Gì Với Marketer Việt Nam? 🤯

So với con số khiêm tốn khoảng 150 công cụ vào năm 2011, khi Scott Brinker lần đầu tiên công bố bức tranh toàn cảnh (Martech Landscape Supergraphic) đầu tiên, chúng ta đang chứng kiến một sự tăng...

MarTech Việt Nam 2025 và Xa Hơn Nữa: Kiến Tạo Hệ Sinh Thái Bền Vững – Từ Tầm Nhìn Đến Hiện Thực Hóa

Làm thế nào để xây dựng một hệ sinh thái MarTech bền vững tại Việt Nam – một hệ sinh thái không chỉ theo kịp thế giới mà còn tạo ra những giá trị đặc thù, phù hợp với bối cảnh và tiềm năng của...

MarTech Stack 2025: Từ "Bộ Sưu Tập Công Cụ" Đến "Hệ Sinh Thái Vận Hành" – Lộ Trình Cho Doanh Nghiệp Việt

Báo cáo MarTech Landscape 2025 với con số hơn 15.000 giải pháp đã khẳng định sự đa dạng của thị trường. Tuy nhiên, việc sở hữu nhiều công cụ không đồng nghĩa với một chiến lược MarTech hiệu quả....